MiniCPM-o 4.5 开源了。这是面壁智能 OpenBMB 在 2 月正式开源的新一代全模态旗舰模型,参数量只有 9B。却对标甚至在多项任务上追平乃至超越一些闭源大模型,被很多人称为端侧 GPT‑4o 平替。

MiniCPM-o 4.5能同时看图/视频、听声音、说话和输出文字。并且支持全双工,也就是一边看一边听的同时还能主动说话,目标是把接近 GPT‑4o / Gemini 2.5 Flash 水平的多模态能力,塞进手机、PC、车机等端侧设备上运行。

MiniCPM-o 4.5 =9B 参数的开源全模态大模型 + 原生全双工实时交互 + 端侧友好部署这几个关键词听着挺炫酷的,用人话解释一下就是:

MiniCPM-o 4.5 =9B 参数的开源全模态大模型 + 原生全双工实时交互 + 端侧友好部署这几个关键词听着挺炫酷的,用人话解释一下就是:

能同时处理图像、视频、文本、音频输入,输出文本和语音。

传统对话式 AI 是对讲机模式,你说完一句,它才开始想、然后再回一句。MiniCPM‑o 4.5 的思路是:让 AI 像人一样,一直在看和听,同时决定什么时候说。

开源地址:https://github.com/OpenBMB/MiniCPM-oHuggingFace:https://huggingface.co/openbmb/MiniCPM-o-4_5

从技术结构看,MiniCPM-o 4.5 可以粗略理解为:在 Qwen3‑8B 语言底座上,接入 SigLIP2 视觉编码、Whisper 语音理解、CosyVoice2 语音生成,再用统一全模态架构打通,做成一个端到端的全模态大脑。 几个关键点值得展开说一下:① 统一的全模态架构不再是视觉模型 → 丢给语言模型的松散拼接,而是从输入编码到输出解码,都由一个统一系统协调文本、语音、图像、视频会在一个共享的语义空间里被理解,这让跨模态推理更自然,比如:一边看视频、一边听声音时,能理解谁在说话、刚刚发生了什么,而不是分别对待音轨和画面② 全双工语音解码语音解码器采用文本 token + 语音 token 交错建模的方式这带来两个直接好处:在输出语音时,仍然可以持续读入新输入,实现真正意义上的全双工,长语音时音色更统一、语气更自然,不容易越说越飘。③ 高效视觉/视频处理借鉴了 MiniCPM-V 4.5 的设计:使用高效视觉 backbone + token 压缩策略,把高分辨率图像和多帧视频压缩到极少的视觉 token 数量结果是:视频理解的性价比极高,在同样的算力预算下,它能看的内容比同类模型多得多,特别适合端侧设备上做长视频分析、实时摄像头理解。

几个关键点值得展开说一下:① 统一的全模态架构不再是视觉模型 → 丢给语言模型的松散拼接,而是从输入编码到输出解码,都由一个统一系统协调文本、语音、图像、视频会在一个共享的语义空间里被理解,这让跨模态推理更自然,比如:一边看视频、一边听声音时,能理解谁在说话、刚刚发生了什么,而不是分别对待音轨和画面② 全双工语音解码语音解码器采用文本 token + 语音 token 交错建模的方式这带来两个直接好处:在输出语音时,仍然可以持续读入新输入,实现真正意义上的全双工,长语音时音色更统一、语气更自然,不容易越说越飘。③ 高效视觉/视频处理借鉴了 MiniCPM-V 4.5 的设计:使用高效视觉 backbone + token 压缩策略,把高分辨率图像和多帧视频压缩到极少的视觉 token 数量结果是:视频理解的性价比极高,在同样的算力预算下,它能看的内容比同类模型多得多,特别适合端侧设备上做长视频分析、实时摄像头理解。

Demo:https://huggingface.co/spaces/openbmb/MiniCPM-o-4_5-Demo

MiniCPM-o 4.5 之所以在开源社区讨论度极高,一个很大的原因是:它不是只活在论文里的模型,而是从一开始就被设计为要在设备上跑。

具体部署方式,可以看下面这个链接:

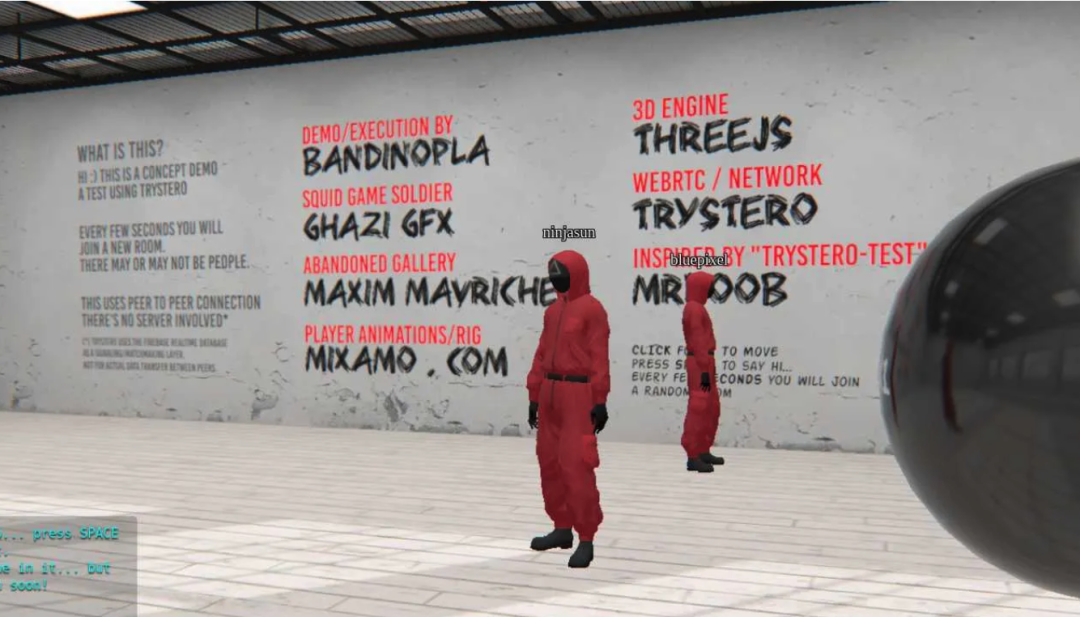

部署指引:https://github.com/OpenSQZ/MiniCPM-V-CookBook/blob/main/demo/web_demo/WebRTC_Demo/README_zh.md

官方已经给出了一整套开源部署方案,包括但不限于:llama.cpp-omni:

- 面壁自研的开源流式全模态推理框架

- 主打端侧/边缘设备上的低延迟推理,支持全双工交互

常见推理框架适配:

- vLLM、SGLang、Ollama、LLaMA-Factory 等

多种量化模型:

- 原始 bf16 约需要 19GB 显存

- int4 量化后内存可降到 约 11GB 或更低,速度可超过 200 tokens/s

在一块主流消费级 GPU 上,跑起一个会看会听会说的全模态 AI。另外在国产算力生态方面,MiniCPM-o 4.5 通过 FlagOS 系统软件栈,已经适配了多家国产芯片,包括:天数智芯、华为昇腾、平头哥、海光、沐曦等对于想在国产硬件上落地 AI 应用的团队,MiniCPM-o 4.5 已经是一个拿来就能跑的成熟选项,而不是停留在 PPT 阶段。04点击下方卡片,关注逛逛 GitHub