1. 问题情境

随着人工智能代理(AI agents)在日常决策支持中的应用越来越普遍,人们开始依赖 AI 协助处理越来越复杂的抉择。这样带来一个张力:如果把太多决策交给 AI,人可能会“失去能动性”;反之,如果 AI 设计带有隐性操控,则可能“丧失自主性”。作者认为这是一种根本性困境。

2. “Nudge”(助推/选择架构)作为前车之鉴

作者回顾公共政策与行为经济学中“nudge”理念——通过设计选择架构(choice architecture)来温和引导个体朝向“更好”方向,而不剥夺选项本身。传统上这种方法被视为兼顾自由与福利的折中方案。

然而,当把这种思路放到 AI 的尺度下(高度个性化、连续干预、海量数据驱动)时,作者警告它可能转变为一种深层次的“数字修辞”(digital rhetoric),即用算法隐晦地引导甚至塑造人们的选择倾向,从而侵蚀自主性。

3. 中心化 vs 去中心化

许多当前 AI 架构与决策推荐系统都集中控制、中心化设计。作者主张,这种中心化方式容易成为控制与操纵的工具,抑制多样性、质疑与个体反思。相对地,他倾向以去中心化和分布式的方式来推动“真理探索”(truth-seeking)。

鉴于以上背景,作者提出以“哲学转向”(philosophic turn)为 AI 设计的新范式。

二、核心主张与方法框架

1. 哲学式(Socratic)对话/探究机制

与传统 AI “推荐 → 引导 → 决策”流程不同,作者主张 AI 应更多扮演“探问者、质疑者”的角色,向用户提出关键问题、揭示假设、挑动反思,而不是直接给出答案或倾向性建议。这样做意在促进用户的判断力提升,而不是成为被动的接受者。

2. 去中心化的真实探索(Decentralized Truth-Seeking, DTS)

作者主张构建一种“分布式探究网络”(inquiry complexes),其中多个主体、多个视角、多个问题交织互动,共同推动知识、判断、信念的演化,而不是由单一中心或平台主导结论。这样的设计可以减少操控风险,并保留开放性与多样性。

3. “Erotetic Equilibrium”(问答平衡)

虽然在论文中不是非常详细讨论,作者提及一种理想状态:即在面对一系列问题与反例后,个体的判断趋于稳定、不再轻易被外部提示扰动。这种平衡状态是一个开放探究系统希望达成的心理/认知稳定点。

4. 自主性保全的设计原则

为使 AI 在实际系统中兼顾“加能(augment)”而非“替代/控制”人类判断,作者列出几类关键特性(paper 中为 sketch,未完全落实):

(1)隐私保护与信息透明性,以防止用户被监控或在“温水煮青蛙”式操控下失去选择感;

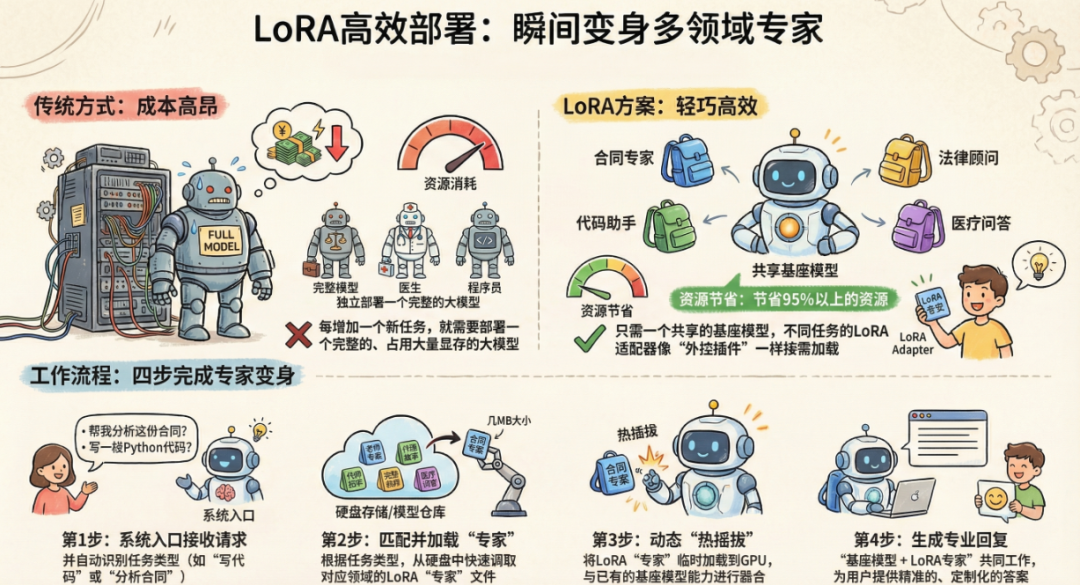

(2)模块化、可替换性和可组合性,让用户有权定制、替换、混合不同探究模块;

(3)互教能力(mutual educability),即 AI 与用户、AI 与其他 AI 间能够相互学习与反馈;

(4)开放生态与互操作性,让不同系统之间的探究成果(问题、逻辑、证据)能够互通、交换。

5. 从“数字修辞”回到“哲学探究”

本质上,这篇论文呼吁一种范式变换:从以策略性说服、优化指标、行为操控为中心的“数字修辞”向以探究、批判、判断为中心的“哲学对话”转变。作者认为,这种转向有助于在 AI 日益普及的时代重建人的自主与能动性。