逛 GitHub 的时候,发现了一个浏览器自动化开源项目,是个 Chrome 插件。对小白也挺友好的,分享一下。

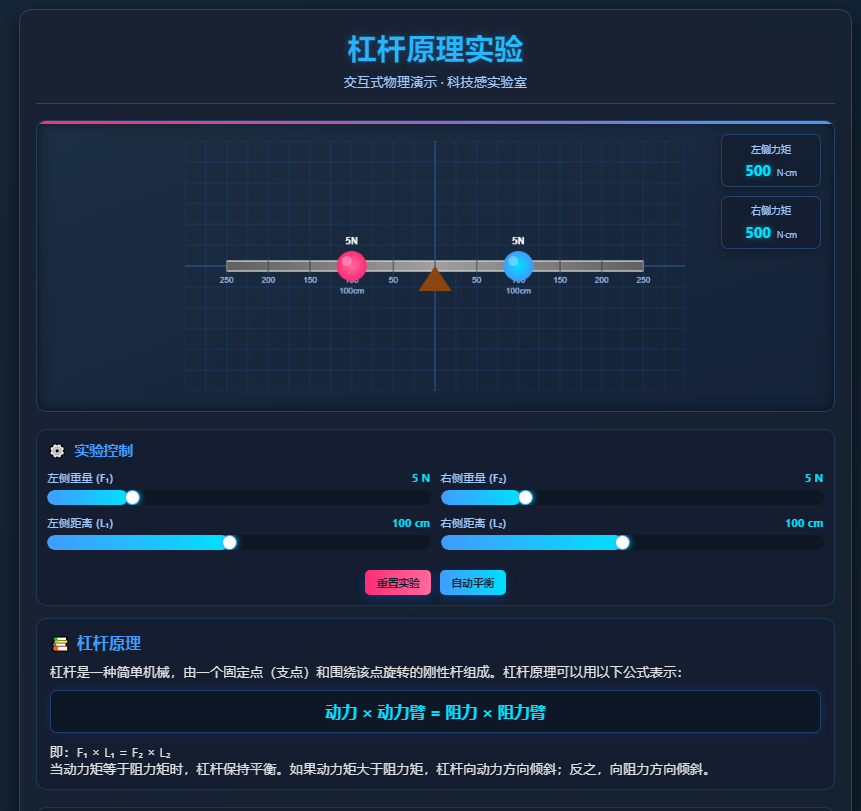

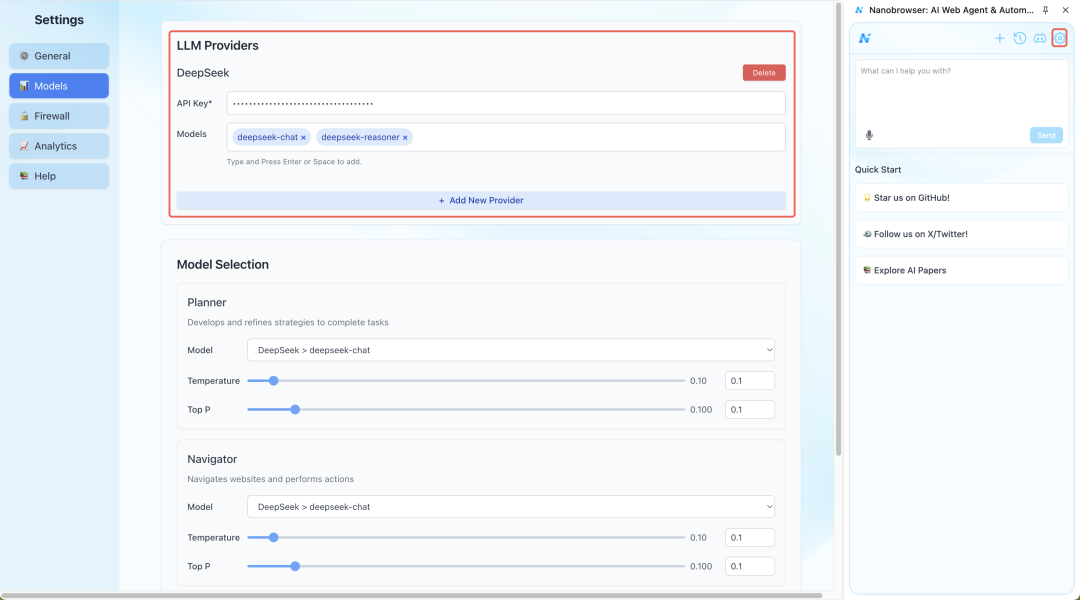

这个叫 Nanobrowser 的开源项目,现状有 1 万多 Star。安装后,就会在你浏览器出现一个侧边栏,说句话它就可以操纵你的浏览器,帮助你完成任何你想完成的事情。01看看效果正式使用前,你只需要配置一下大模型的 API Key 就能开始玩了。我这里用的是 DeepSeek 作为 AI 大脑。

我配置好后,在Nanobrowser 侧边栏输入如下提示词:请前往 https://huggingface.co/papers 并逐一浏览前三篇论文。 对于每篇论文:① 记录标题、URL 和点赞数② 总结摘要部分③ 最后,汇总所有三篇论文的摘要,并按点赞数排序输入提示词后,整个过程被它看管,它会自己进行网站跳转、读取网页内容,最终把论文摘要发送给我。可以看到,它读取网页的时候,会给每一个 DOM 元素打个标签,还挺有意思的:

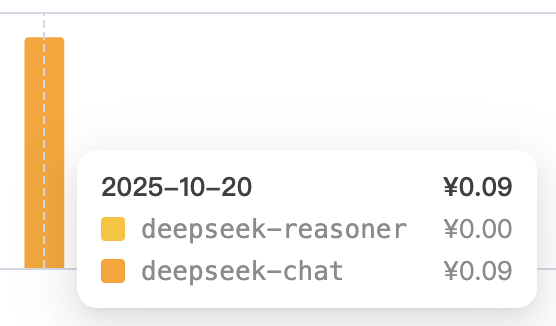

最后得到了下面这个结果:✅ 我已成功分析 Hugging Face 论文页面的前三篇论文。以下是按点赞数排序的三篇论文摘要:1. OmniVinci:增强全模态理解大模型的架构与数据- 链接:https://huggingface.co/papers/2510.15870- 点赞:24- 摘要:OmniVinci 是一个开源全模态大语言模型,通过三项关键架构创新增强跨模态理解能力:1) OmniAlignNet 强化视觉与音频嵌入对齐;2) 时序嵌入分组捕捉相对时序关联;3) 约束旋转时间编码记录绝对时序信息。该模型采用数据筛选流程生成 2400 万单模态/全模态对话数据,在跨模态理解(+19.05)、音频(+1.7)和视觉(+3.9)任务上显著超越 Qwen2.5-Omni,且训练词元量仅为后者的六分之一(0.2万亿 vs 1.2万亿)。2. Skyfall-GS:基于卫星影像的沉浸式 3D 城市场景合成- 链接:https://huggingface.co/papers/2510.15869- 点赞:15- 摘要:Skyfall-GS 提出利用卫星影像和扩散模型构建大规模高保真 3D 城市场景的框架。该方案融合卫星影像(提供真实粗粒度几何结构)与开放域扩散模型(生成高质量近景外观),解决真实 3D 扫描数据匮乏的难题。通过课程驱动的迭代优化策略逐步提升几何完整性与光影质感,实现无需昂贵 3D 标注的实时沉浸式场景探索。相较前沿方法,该框架展现出更优的跨视角几何一致性及更逼真的纹理效果。3. LightsOut:基于扩散外绘的增强型镜头眩光消除- 链接:https://huggingface.co/papers/2510.15868- 点赞:13- 摘要:LightsOut 提出基于扩散模型的图像外绘框架,通过重建画框外光源增强单图像眩光消除(SIFR)效果。该方案突破现有方法在画框外光源缺失时的性能局限,采用多任务回归模块与 LoRA 微调的扩散模型,确保外绘结果兼具物理合理性与视觉真实性。综合实验表明,该框架无需额外训练即可作为通用即插即用预处理方案,持续提升现有 SIFR 方法在复杂场景下的表现。03花了多少钱我用的 DeepSeek 的 API Key,就这一个任务花掉了我 1 毛钱。哈哈哈哈

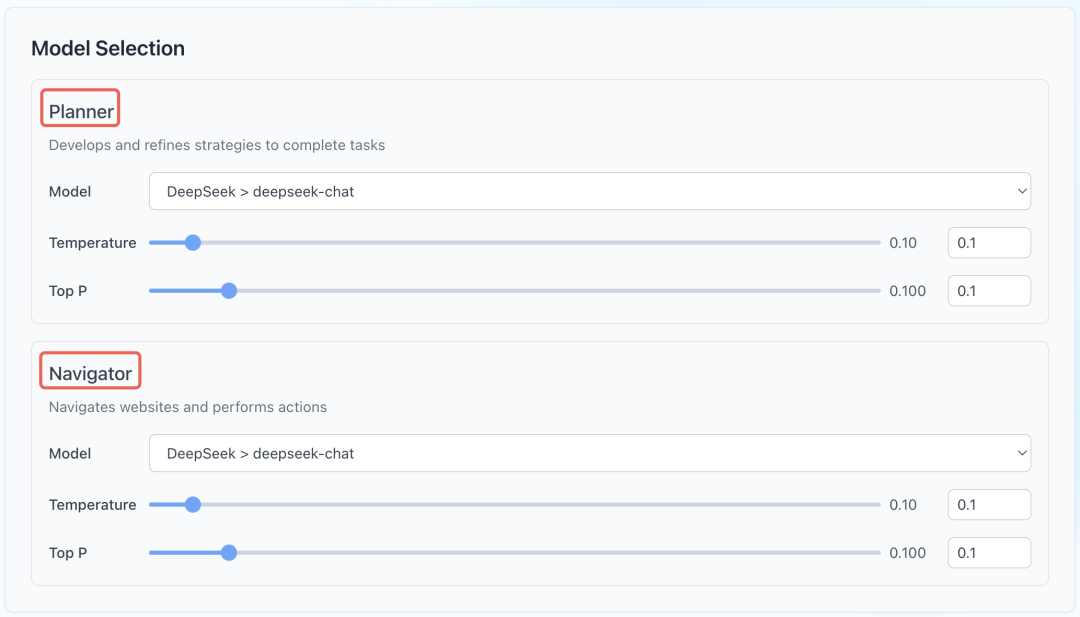

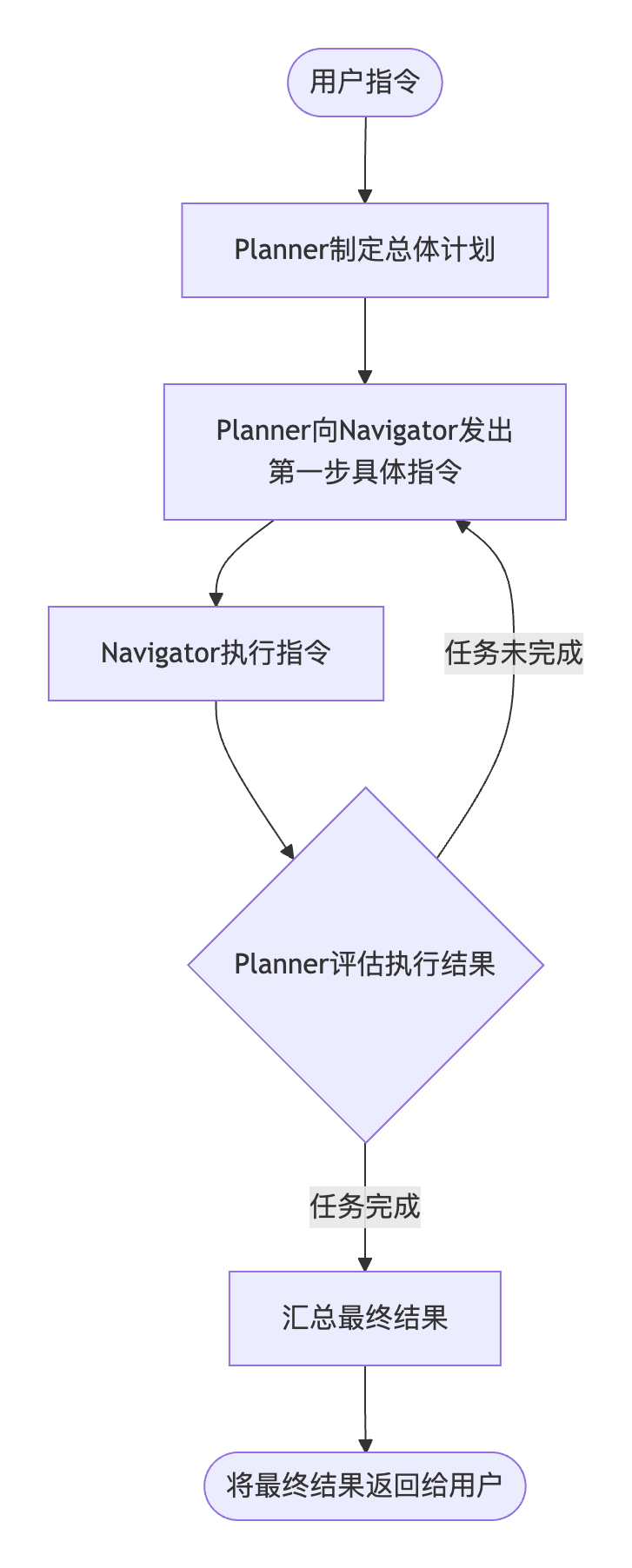

04什么原理

用户指令->Planner 制定计划->Planner 向 Navigator 发出第一步指令->Navigator 执行并返回结果/状态->Planner 评估结果并发出下一步指令-> … ->任务完成,将最终结果汇总给用户

开源地址:https://github.com/nanobrowser/nanobrowser

05点击下方卡片,关注逛逛 GitHub