过去这一年,我几乎把全部业余时间都花在了「造 Agent」这件事上。

从最早用 LangChain 做简单的聊天机器人,到后来构建能自动规划、调用工具、执行任务的复杂系统——我踩了无数坑,也见证了 Agentic AI 这一领域的快速迭代。但越深入,我越发现一个现实:要打造一个能稳定上线、真正有用的 AI Agent,比想象中难太多。

模型在变,框架在换,社区的范式一茬又一茬,很多人刚刚学会了 ReAct,又冒出个 Plan-and-Execute;刚理解了思维链,又被「反思式规划」打了个措手不及。我深刻体会到,Agentic AI 并不是“把大模型接个接口”那么简单。

它更像是一次“架构艺术”:你要让这个“数字生命体”具备稳定性、效率、自主性与可用性——四个维度缺一不可。所以,今天我想写下这一篇,算是过去一年折腾出来的经验总结:

2025 年,每个想认真做 Agent 的人,都该掌握的 6 大设计模式(Design Patterns)。这些模式不是概念,而是能在真实项目里让你少踩坑、快落地的“工程套路”。

如果你想让你的 Agent 不只是一个“聊天模型”,而是一个能自我规划、执行、反思、协作的智能系统——这些模式就是你必须懂的基石。什么才算一个“好用”的 Agent?做 Agent 的人都会经历同一个阶段:模型已经能跑通了,但总觉得哪里“不对劲”。

不是卡在一半就报错,就是对同一个问题反复回答,或者一旦脱离训练场景就彻底“迷路”。

我后来意识到,真正的好 Agent,和写好一段代码、设计好一个产品没什么不同——它得稳、快、能、自然而可信。

1. 稳定性(Robustness)

稳,是基础。

一个真正能上线的 Agent,必须能在“乱七八糟的现实”里活下去:

网络延迟、API 挂掉、用户输入不规范、数据缺失……这些都得扛得住。我印象很深,有一次我在做一个“智能客服 Agent”,遇到用户输入“我想退货”,但下一句话是“因为猫咬坏了盒子”,系统居然直接报错。原因是输入结构被识别成了异常格式。那一刻我突然明白,稳定性的关键不只是模型理解力,而是输入校验、错误兜底、冗余机制这些工程细节。从那以后,我在每个 Agent 架构里都会加:

- 严格的输入检查(Input Validation)

- 出错时的 fallback(兜底逻辑)

- 边界测试(Edge Case Testing)

这些听起来“没技术含量”,但它们决定了一个 Agent 能不能“从实验室活到生产环境”。2. 效率(Efficiency)

第二个标准是“快”。

在生产环境里,效率直接决定体验。响应慢 3 秒,用户就会退出;耗费太多计算资源,公司就不让你上线。我在优化时,学到几个实用招:

- 常用数据缓存(Caching)

- 避免重复调用(减少 API 轮询)

- 精简中间步骤(Prompt Chaining 时减少无效传递)

尤其是在边缘设备或低算力环境中(比如在车载系统或 IoT 场景里跑 Agent),效率优化几乎是生死线。3. 自主性(Autonomy)

第三个标准是“能自己做决定”。

这也是 Agent 与普通聊天机器人的最大区别。

真正的 Agent,不应该每次都等人指令,而是能根据场景、数据和历史上下文,自主判断下一步要干什么。举个例子:

我做过一个智能家居 Agent,它能根据室内温度和用户习惯自动调节灯光和空调。关键在于——它不是靠硬编码逻辑,而是通过传感器数据+记忆模块做出判断。

这种“自我决策”的能力,让 Agent 从“被动执行者”变成了“主动助理”。要实现自主性,你必须在设计里考虑:

- 决策算法(Decision Models)

- 感知通道(Sensors / Context Awareness)

- 多 Agent 协作逻辑(Multi-Agent Collaboration)

4. 可用性(Usability)

最后一点,也是最常被忽视的一点:可用性。

一个再聪明的 Agent,如果交互方式反人性,用户也不会用。我花了很久才理解,Agent 的可用性不仅仅是“界面好看”,而是“让人信任、让人敢用”。

比如:

- 给出清晰的反馈,而不是沉默几秒。

- 提醒用户它正在执行任务。

- 在遇到模糊请求时,主动反问确认,而不是胡乱猜。

这些小细节,决定了 Agent 能不能从“技术演示”变成“用户真正想留下的产品”。我曾经也天真地以为,只要我有一个足够强的模型,比如 GPT-4、Claude 或 DeepSeek,那 Agent 自然就能“聪明”起来。

直到我真正开始写第一个多轮任务代理——它一上来就彻底把我整懵了。模型不是不会思考,而是没有结构化的思考路径。

没有设计模式的 Agent,就像一个即兴发挥的演员,灵感可以有,但稳定输出几乎不可能。那时候,我才真正理解什么叫「Design Pattern」——它不是教你造模型,而是教你造能工作的系统。在 AI 工程领域,设计模式的意义就像建筑师的结构图纸:

它帮你在混乱的任务之间建立逻辑秩序,

在一次次“重造轮子”之前,给你一套经过验证的架构模板。我后来总结了几个理由,为什么任何一个想做 Agent 的人都该学设计模式:

- 标准化解决方案(Standardization)

不同人写 Agent,如果都用相似的模式,团队协作成本就会低得多。

你只要一句话:“这里用的是 ReAct + Reflection 模式”,对方立刻就能脑补出逻辑。 - 节省时间(Efficiency of Reuse)

每次都从头写任务路由、错误处理、反思循环?不如直接复用经典模板。

设计模式的价值在于——它让我们不必再“从 0 发明轮子”,而是直接在成熟方案上做创新。 - 提升代码质量与可维护性

我见过太多 Agent 项目,一开始能跑,后来越修越乱,最后彻底失控。

设计模式其实是“架构上的约束”,它强迫你在逻辑上保持干净、清晰和可扩展。 - 让团队有“共同语言”

当我们都知道“Prompt Chaining”“Reflection”“Tool Use”“Planning”这些术语,

我们就能更快讨论问题、复盘架构,而不是陷入模糊的口头解释。

我常说一句话:

设计模式是 Agent 世界里的“武功心法”。

模型是内功,Prompt 是招式,而模式,是你走火入魔前的一道护身符。

掌握模式,你才能真正把“智能”变成“系统”;

否则,你的 Agent 只会停留在“玩具阶段”。接下来,我想分享我过去一年里亲手实践、踩坑总结出来的6 大关键模式。

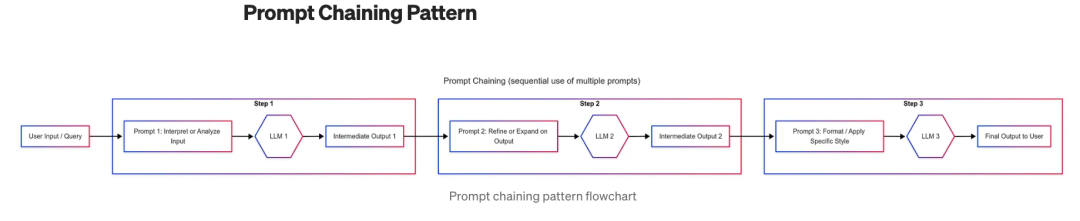

每一个都解决了 Agent 进化路上的某个“卡点”:1️⃣ Prompt Chaining —— 拆解复杂任务

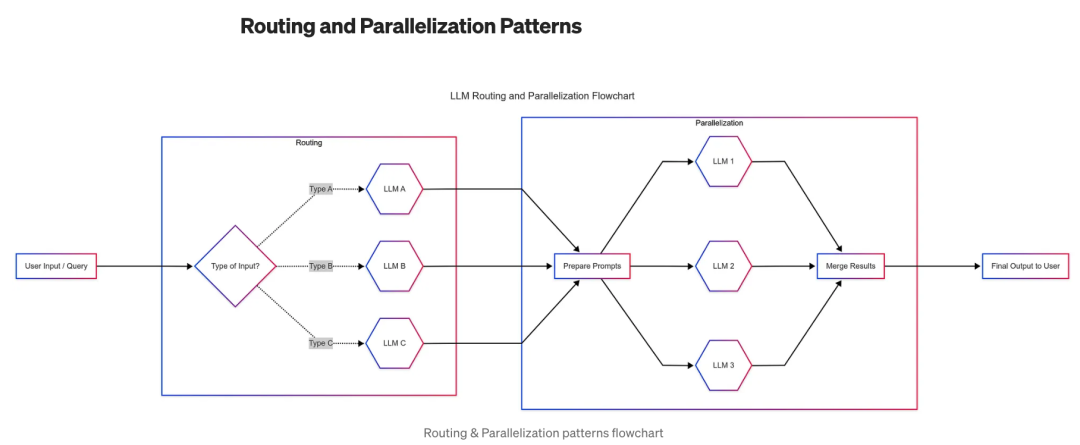

2️⃣ Routing & Parallelization —— 动态决策与并行执行

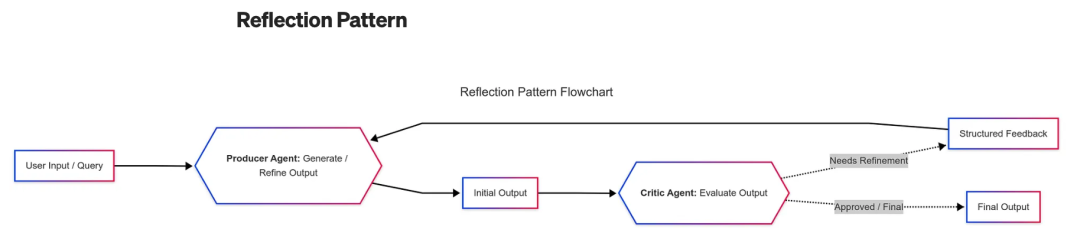

3️⃣ Reflection —— 自我反思与改进

4️⃣ Tool Use —— 打破封闭模型的边界

5️⃣ Planning —— 多步推理与目标分解

6️⃣ Multi-Agent Collaboration —— 多智能体协作这些不是“听起来很酷”的名词,而是我真正在项目中依靠它们,让系统从“乱七八糟”变得“稳定如钟”。Prompt Chaining ,让模型不再“一口吞掉整只大象”刚开始写 Agent 的时候,我犯过一个特别典型的错误:我总想着能不能“一条大 Prompt 解决所有问题”。

比如我想让模型同时去“读文档 → 提取关键数据 → 写总结 → 发邮件”,我就写了一条又臭又长的指令,希望它一次性搞定。

结果当然是:

模型不是漏信息、答非所问,就是半路崩溃。那一刻我才真正体会到——没有人能一口吞掉一头大象,模型也不行。于是我开始学着拆解任务,这就是 Prompt Chaining 的精髓。

它的核心理念非常朴素:把复杂任务拆成一连串小任务,让每一步更简单、更可控。

每一步的输出,成为下一步的输入。就像流水线,每个工人只负责一个环节,最终拼出完美的产品。我第一次用它,是在做一个“报告生成 Agent”。

起初,模型写出来的报告逻辑混乱,数据错位。

后来我改成 Prompt Chaining 流程:

1️⃣ 第一步让模型摘要文档;

2️⃣ 第二步让它提取关键数据点;

3️⃣ 第三步再让它撰写最终报告。神奇的是,整个过程的准确率和可控性都提升了好几倍。

我甚至能针对不同步骤用不同的模型,比如摘要用 Claude,报告生成用 GPT。

这时候,我才意识到:Prompt Chaining 其实就是「以任务为导向的思维链」。它的三个优势特别明显:

- 可控性:每一步都可以校验、微调,错误不会被放大。

- 可靠性:逻辑分层后,模型能更稳地遵循上下文。

- 可扩展性:你可以随时在链条中插入“工具调用”“外部查询”等模块。

举个最典型的例子:

别再让模型直接回答“帮我总结这份报告并写封邮件”。

正确的做法是:

Step 1: 总结报告 → Step 2: 提取关键数据 → Step 3: 写邮件。

这样不仅更准,还能清楚知道是哪一步出了问题,调试体验直接提升一个量级。从那以后,我几乎再也不用“大一统式 Prompt”。

因为我知道,真正稳定的智能,不靠“巨大的指令”,而靠“优雅的分工”。那一刻我突然意识到,这正是我所期待的智能体时代的样子——不再是冷冰冰的指令执行者,而是真正能「陪伴」人类完成复杂任务的伙伴。它不需要我们一遍遍重复目标,也能主动帮我们规划路径、发现盲点、优化方案。

反思式规划(Reflective Planning)就是这种能力的核心。

它的逻辑像人类的思考闭环:

先做,再看,再想,再改。

在这个过程中,Agent 不是一条直线地完成任务,而是不断在「行动→反思→再规划→执行」之间迭代,像人一样成长。比如我在实验一个自动写作 Agent。第一版的输出总是风格僵硬,逻辑生硬。于是我加了一个反思模块,让模型自己审阅生成结果,并写下“改进建议”。

第二轮,它开始分析段落衔接是否自然,主动调整语气。

第三轮,它甚至能总结出自己的问题:“标题不够吸引人,下次要多用悬念句。”

那一刻我有点震惊——它真的在「学」。这就是反思式规划的魅力。

它不仅让Agent能完成任务,更让它在完成任务的过程中变得“更聪明”。

而当这种能力被广泛应用时,我们看到的将不仅是更高效的AI,而是一种全新的工作范式:自主、反馈、演化。我相信,未来的智能体不再是工具,而是共创者。

他们会懂得判断优先级,会主动提出优化建议,会像团队成员一样协作。

而我们人类,也将从重复执行中解放出来,转向更具创造力与战略性的工作。

当然,这条路仍然漫长。

从 Chain-of-Thought 的线性思维,到 ReAct 的互动感知,再到 Plan-and-Execute 的分层规划,最后到 Reflective Planning 的闭环反思,每一步都在让 Agent 更像人。

但也正是这种“拟人化的智慧演进”,让我们看到 AI 不只是工具,而是一种新的思维方式。当我回头看吴恩达提出的“Agentic Workflows”时,心中那份激动依然清晰。

这不仅是AI发展的技术路线,更是人类与机器协作关系的一次重塑。

我们正在进入一个“共思”与“共创”的时代——

AI 不再是命令的执行者,而是思维的延伸。而我,正站在这个浪潮的边缘,

带着好奇、敬畏和一点点野心,

想看看:

当智能体真正学会反思的那一天,

人类会不会也被迫重新思考——

我们自己,究竟还剩下什么是“独一无二”的?