像是很多视频长的离谱,但是核心的信息却又不多,又或者你搞了很多视频,想基于这些视频去问一些问题,没有视频RAG可能就很浪费时间。

我们已经习惯了把几十万字的文档丢给模型去总结,所以AI这么强,视频肯定也是需要这么做的。

今天给大家推荐个港大开源的项目,Vimo。

视频的AI互动,也算是更进一步。

项目简介

VideoRAG 可在单张RTX 3090显卡上运行,还有能直接下载使用桌面应用 Vimo,让理解长视频像查阅文档一样简单高效。

性能很猛,还是放个指标图吧。

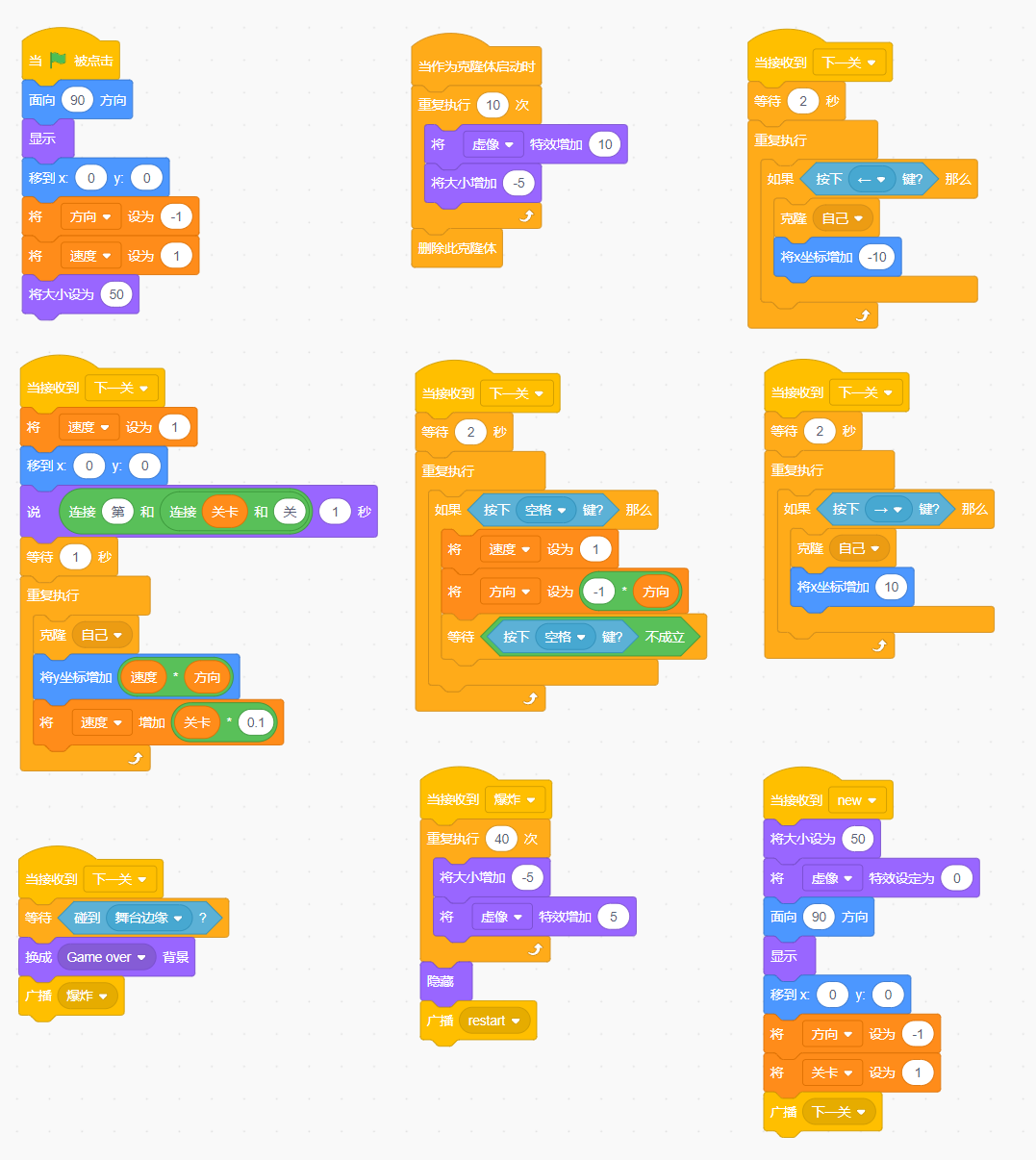

实现逻辑

视频上传后,并不会直接把整个视频丢给LLM,因为单纯靠一个模型的能力没办法分析这么长的视频。

1、切分与描述:

把长视频切成很多个小片段,比如每几秒一段,或按镜头切。

然后用视觉模型把每一段画面变成文字描述,比如一个穿红衣服的人在跑步。

同时用ASR提取音频字幕。

2、构建知识图谱

这是VideoRAG的核心。

普通的RAG只是把片段存起来,VideoRAG会进一步分析这些片段,提取实体(人、物体、地点)和关系。

它会画一张关系网,比如人物A -> 在第5分钟 -> 拿起了 -> 物体B。这样系统就有了全局的故事脉络,而不仅仅是碎片的画面。

第二步:混合检索

当你问一个问题,比如“那个红衣人最后去哪了”,就会按照下面这样运行。

- 关键词匹配:系统去图谱里找“红衣人”这个实体,看看它在视频的时间轴上都和哪些场景有关联。

- 语义搜索:系统通过向量检索,找到和“去哪了”含义最接近的视频片段和对话字幕。

- 双重确认:VideoRAG会同时结合宏观的图谱信息和微观的片段信息,锁定最相关的几段视频内容。

第三步:生成回答

最后一步就简单了,系统把检索到的相关片段描述、相关字幕以及图谱中的上下文信息打包喂给大模型。

大模型根据这些线索,生成最终的回答“那个红衣人在视频的15:30处走进了一家咖啡馆”。

项目链接

https://github.com/HKUDS/VideoRAG

© 版权声明

文章版权归作者所有,未经允许请勿转载。