自生成式人工智能工具(如 ChatGPT、Claude、Copilot 等)进入教育场域以来,教育评价成为最先受到冲击、也最具争议的领域之一。

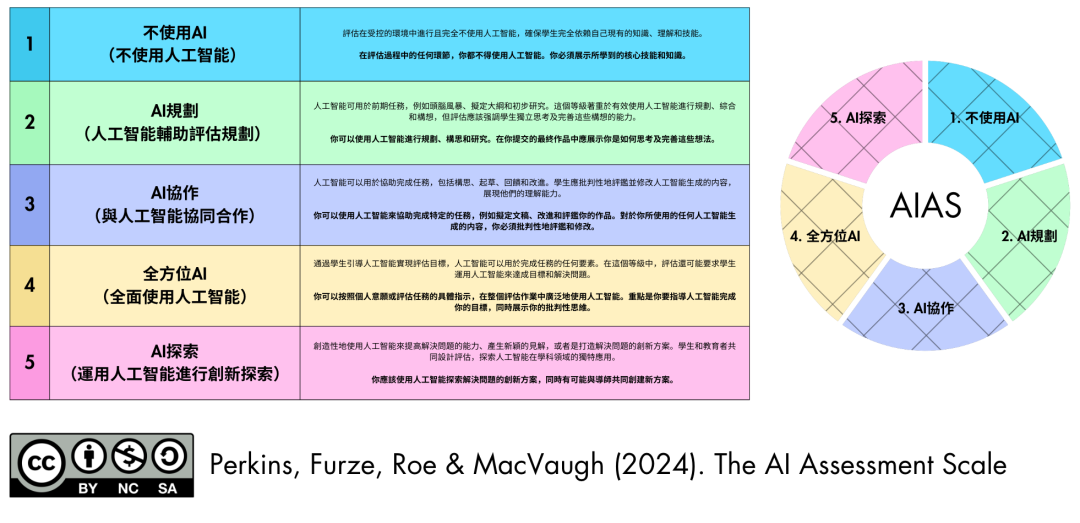

人工智能评估量表(AIAS)由Mike Perkins、Leon Furze、Jasper Roe和Jason MacVaugh开发。该量表于2023年首次推出,并在第二版(2024年)中进行了更新,为将人工智能融入教育评估提供了一个细致入微的框架。

AIAS 已被全球数百所学校和大学采用,被翻译成了包括简体中文在内的30多种语言,澳大利亚高等教育质量与标准署 (TEQSA) 在其 2024 年的文件中指出,AIAS 可作为协助将 GenAI 应用于评估的选项。

https://leonfurze.com/2025/08/18/five-principles-for-rethinking-assessment-with-gen-ai/1. 效度优先:从根源上化解AI挑战此原则要求我们将战略重心放在评估的根本目的上:它是否有效测量了我们预设的学习目标?在担忧AI被滥用之前,我们必须首先确保评估任务本身是值得完成的。这或许是反直觉的第一步,因为我们的本能是直接应对作弊威胁。然而,一项高阶、有效的评估天然具备对AI的“免疫力”。例如,一份要求学生对比分析三篇观点相悖的学术文献的论文,其效度远高于一篇简单的文献综述。前者评估的是批判性综合能力,这是AI难以独立完成的;而后者则极易由AI代劳。从源头确保效度,AI的挑战便迎刃而解。2. 为现实而设计:在AI的边界处命题这一原则倡导我们设计“真实性评估”(Authentic Assessments),即立足于生成式AI的能力边界进行命题,清晰界定AI能做什么、不能做什么,并将评估重点置于其能力范围之外。这种设计思路促使我们跳出传统的信息检索或内容生成任务,转而创造那些需要人类独有智慧才能完成的挑战。这些任务考验的是批判性思维、深刻的个人反思,以及将知识应用于真实世界复杂情境的能力。例如,要求学生将课堂理论应用于其实习经历的案例分析、进行需要现场应变的口头答辩(viva voce)、或完成一项需要与社区成员协作的本地化项目。这些都是AI无法替代的人类高阶能力展示。3. 透明与信任:构建合作而非对抗的关系此原则的核心在于与学生建立清晰、坦诚的沟通渠道,并就学术诚信与AI等工具的合理使用,共同设定并坚守高标准的期望。我们的战略重点应是建立一种基于信任的文化,而非陷入与学生的技术军备竞赛。通过设定明确的指导方针,我们赋能学生成为负责任的技术使用者,将AI视为学习的辅助工具,而非投机取巧的捷径。这种合作关系远比单纯的防范与监控更具教育意义和长远价值。4. 评估即过程:让学习轨迹无可取代该原则主张,评估不应是终点处的一次性高风险考试,而应是贯穿于整个学习周期、持续发生的动态过程。在AI时代,这种方法的战略优势尤为突出。过程性评估,如草稿的迭代、作品集的构建、定期的师生研讨,能够让教育者洞察学生知识建构的全貌。它揭示了学生思维的演进——那些走过的弯路、反复的修正和灵光乍现的“顿悟”时刻。这条真实而独特的成长轨迹,是当前任何AI都无法伪造或复现的,从而让评估回归学习本身。5. 尊重专业判断:回归教育者的核心价值最后的原则强调,无论技术如何发展,经验丰富的教师永远是评判学生学习成效与深度的最佳人选。在一个自动化工具不断涌现的时代,教育者基于经验和观察做出的细致入微的专业判断,其价值不减反增。它能穿透单一作业的表象,看到学生在工具能力之外的真实潜力与困惑。最终,教师的专业判断是串联起前四项原则的纽带。只有教师才能判断一项评估是否真正有效(原则一)、任务设计是否超越了AI的局限(原则二)、与学生的信任关系是否牢固(原则三)、以及在评估过程中看到了学生真实的成长轨迹(原则四)。

归根结底,健全的教学原则才是我们应对技术变革最坚固的防线,也是将AI等新工具智慧地融入教学的最佳路径。因此,我们面临的问题或许应该转变:与其问如何阻止学生使用AI,不如问我们如何设计出让AI都相形见绌的、真正考验人类智慧的评估任务?真正的挑战不在于如何限制 AI,而在于是否有勇气直面长期以来被忽视的评价问题:我们是否真正评价了重要的学习?我们是否信任教师的专业判断?我们是否把评价当作学习的一部分?在生成式人工智能时代,教育评价的重构,终将回到一个看似古老却从未过时的问题:我们希望学生成为什么样的人,以及评价如何为此服务。这个也与前几天自留地发表的《人工智能时代,请停止给答案打分,开始转向给学习者的思考过程打分》的观点是一致的!

快看,快看!人工智能那滔天巨浪正扑面而来而我们却还在那海滩上专心致志地捡垃圾