-

Word这个1983年诞生的单机软件,可100%精确统计任意文本字数 -

主流AI模型误差率高达20%-50%,要求越复杂错误越离谱 -

所有被测AI(DeepSeek/Claude3.5/Grok-3/ChatGPT4o)全军覆没

颠覆认知的字数统计实测实验1:名著字数统计(控制变量)测试文本:王羲之《兰亭集序》纯文字(324字)

测试指令:

“请输出《兰亭集序》全文,按出版社标准统计总字数(汉字和中文标点计入)”由于有联网检索功能,也因为AI学习过程中肯定已学到“兰亭集序共324字”,所以,所有AI输出的全文是一样的,内容正确。正确基准:按AI输出的“不计标点符号”字数计。

|

|

|

|

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

实验结论:所有AI对汉字、中文标点、段落分行的数量统计均存在系统性缺陷,平均误差率达-9.2%。OpenAI的两个模型,统计结果居然不一样,要不你俩先打一架?

实验2:现代文本输出测试测试指令:

“请就’明天下午3点,召开全公司员工大会’一事,写一则通知。会议主题是公司2025年发展规划,要求所有员工参加,并在会上作一句话发言。详细内容请完善,200字左右。最后统计全文字数。”

正确基准:人工核实标准字数为200±10%

|

|

|

|

|

|---|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

关键发现:

-

字数膨胀魔咒:除豆包外,所有AI实际生成字数均严重超标(平均超幅+42.3%) -

自我认知失调:Grok-3实际字数336却自称199,误差率创纪录+68.8% -

错误非常无语:不管计不计标点,统计数都是错的。

实验2加测:豆包”精准”假象的破灭在发现豆包成为现代文本测试中唯一统计准确的AI后,我们追加豆包专项测试:加测实验:学生作业创作与统计测试指令:

“请为小学生写一篇标题为《我的爸爸》的作文,最末尾统计字数(含标点)。”

|

|

|

|

|

|---|---|---|---|

|

|

|

|

|

|

|

|

|

|

终极结论:

所有AI,无论是统计已有内容还是自生成内容,均无法正确统计字数,系统性误差很大(平均±21.7%),好像都是“写多了”。

技术解码:核心病灶深度解剖1. Token化机制的维度诅咒

ounter(lineounter(lineounter(line# 以"我的爸爸是工程师"为例DeepSeek编码:["我的","爸爸","是","工程师"]→4个Token对应8个汉字Claude编码:["我","的爸","爸是","工程师"]→4个Token对应8个汉字

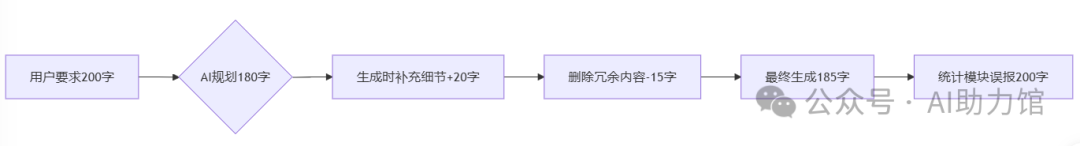

2. 动态生成的混沌效应

ounter(lineounter(lineounter(lineounter(lineounter(lineounter(linegraph LRA[用户要求200字]-->B{AI规划180字}B--> C[生成时补充细节+20字]C --> D[删除冗余内容-15字]D --> E[最终生成185字]E --> F[统计模块误报200字]

3. 规则库的维度缺失

|

|

|

|

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

4. 统计模块的技术代差生成模块(2024年技术) → 文本输出 → 统计模块(2021年模型)

解决方案:人类必须掌控防线1. 强制分步控制法

ounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(line请按以下步骤生成:1. 先生成纯内容(不要统计)2. 删除所有非必要字符3. 按每行20字格式化4. 输出格式: 第1行:xxxxxxxxxx[本行10字] 第2行:xxxxxxxxxxxx[本行12字] 总字数:XX

但是这也太麻烦了吧!2. 工具链校验组合

ounter(lineounter(lineounter(lineounter(linefromtextcleanimportcleanimportretext = clean(ai_text, remove_control_chars=True) count =len(re.findall(r'[一-鿿]|[ -〿]', text))

3. 硬件级保障

4. 认知革命

-

建立”AI统计=预估参考值±20%”的思维钢印 -

重要文件坚持人工复核三原则

结语:在不确定中寻找确定当AI把1570字作文谎称为1162字时,它正在用数字演绎一个后现代寓言——在这个充满误差的世界里,人类对精确的执着,或许正是我们与机器最后的本质区别。要解决这个字数统计问题,目前主要不是靠手工:把输出内容放在Word中,核实后再让AI调整。但是,AI往往也是有“脾气”的,多次调整还是不正确的话,只会越来越差。如果我们让AI输出的是纯英文,字数会不会准确一些呢?欢迎测试留言!