阿里刚上线的Wan2.6已经可以做到单次生成的严格一致性和多镜头叙事了,

也可以很轻松的一次生成创意产品展示,

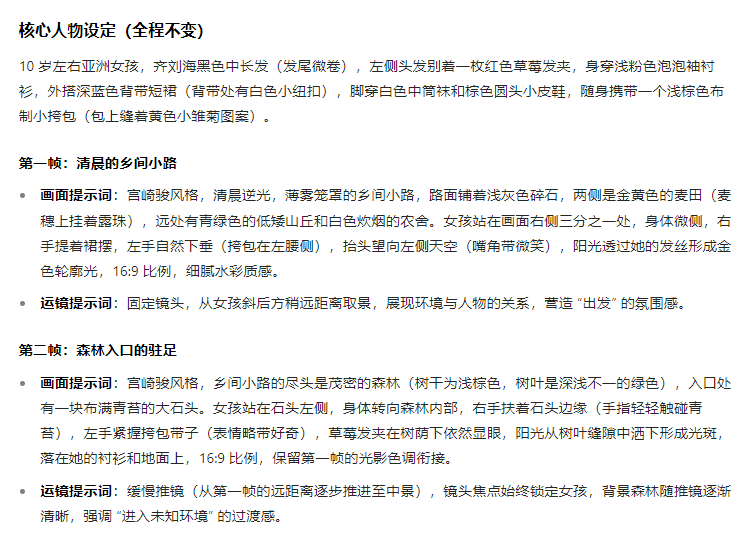

除了视频质感的提升,这把还更新了几个新功能,可以指定⻆⾊演出,支持多镜头智能调度,音画同步生成。来看看他们的宣传片,从切换镜头到角色一致到开口唱歌,整体来说完成度极高,我当然要来测试一把。

长话短说,内测了两天的使用感受是,一致性比我想象中的强,有种Sora2刚上线时候的既视感,提示语遵循能力比上一代强很多,能完成多镜头的生成。

先来看看角色扮演功能,上传一段2-5秒的视频,

我的建议是使用正脸无遮挡的视频来制定角色,

当然,这个角色不只局限于写实的人物,卡通、宠物、道具等等都可以,

来到视频生成页面,目前一次最多可以生成10s的视频,可以调用两个角色进行合拍。比如我这里用我的角色和我家小猫做了一个平时的日常,选择角色扮演模式,提示语直接通过@角色的方式去写就可以。

每次镜头切到我自己的时候根本就忍不住笑,我要做100条我和小猫的日常,有人想看吗?我还做了一个小猫说话了的版本,猫咪嘴部的动作也很自然。而且这次碰到杯子的物理接触也更加真实了。

目前万相2.6对于单一角色的参考是非常稳定的,能够高清还原人物角色的细节,比如做日常拍摄经常会遇到的单人的不同景别切换,现在一条提示语就能搞定,

PS,现在sora2限制真人的图生视频,wan2.6就没这烦恼。双人对话的互动场景稳定的也很高,还能做出不同的音色,我就实现了和大圣一边烤串一边聊天,

从角色扮演的功能中就已经展示了万相2.6在使用角色扮演的同时就能够实现多镜头切换和音画同步的效果了,除了真人效果的生成之外,我还测试了万相2.6其他方面的质量,比如,这个煎荷包蛋的效果,从黄油放进锅中,到打鸡蛋下锅,再到蛋慢慢煎熟,就最后一个镜头这个蛋清煎熟的过程,我梦回veo3刚出做真实物理的场景。晚上想吃夜宵了可以做这样一条消磨时间,说不定就不想吃了(才怪)

除了写实之外,万相2.6做风格化的视频效果也很不错,比如这个粘土风格的小人效果,人物动作,画面风格和音效都挺统一的,看不出什么违和感。

又或者我可以只告诉万相2.6一句,

它也能做到制作一个完整的15秒广告视频,分镜和台词都自动给我匹配好,小猫的动作丝毫不崩,这效果我说实话不输sora2,清晰度还更好。

我还可以指定角色出演指定产品广告,比如让我给这瓶wan可乐拍个广告,全程我和产品都保持着一致性,wan2.6自己也有很强的广告思维,设计的台词和分镜都符合广告的特点。如果我是品牌方想要保持我的短视频帐号日更,还真可以用这个了,成本又低,剧情又有意思,每天roll几个视频发一发保持粉丝黏度,爽爽爽

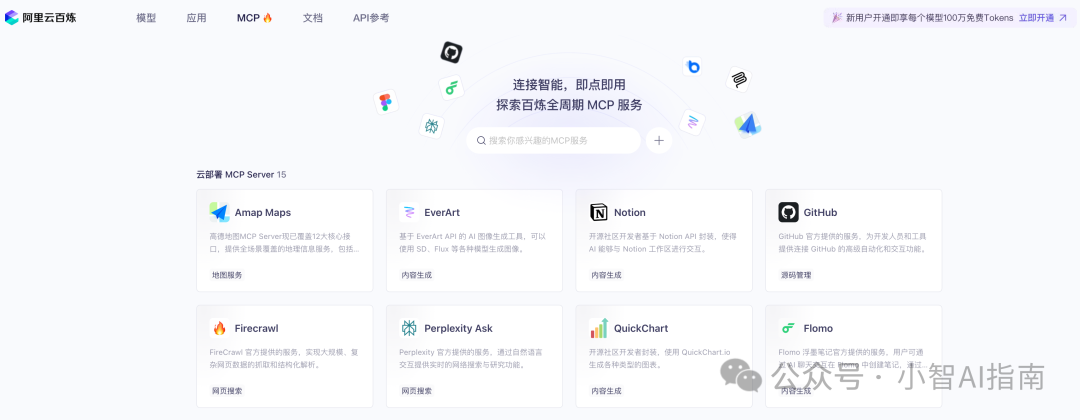

最后的最后,目前在百炼和万相官网上都可以使用啦,地址我就贴这了。🔗bailian.console.aliyun.com/?tab=model#/model-market/all?providers=wan🔗tongyi.aliyun.com/wan/不知道大家有没有感受到,现在AI视频都朝着多镜头,多参考角色,音画同步这三个方向集体补课。我用下来会觉得这三条进化方向,本质上都在解决同一个问题,

就是把视频生成从能出片推进到能交付。因为做AI做单个镜头的天花板已经很高了,而在真正的影视行业中,真实内容的最小单位是镜头组,不是镜头,短视频,广告,短剧,MV,产品演示,本质上是剪辑语言的表达,远景交代空间、中景推进动作、特写传递情绪,再用转场把节奏打出来。以前AI只会生成一个镜头的结果就是,我们还是要回到剪辑软件里把故事拼起来,交付链路会断在最后一步。所以,大家可能会感觉到能做出好作品的,还是之前懂影视知识,会动手剪辑的那一波人。但现在,多镜头+参考角色+音画同步,这三条线糅合在一起后,生成模型更像是一个导演系统了,这就是在无限缩小普通人和技术人之间的差距,人人都能做1分钟导演,这牛已经不需要吹了。

@ 作者 / 阿汤 & 卡尔